NVIDIA anunció en el día de hoy su GPU tope de gama para Inteligencia Artificial (IA) generativa y plataformas de alto rendimiento (HPC), la Hopper H200. Eso sí, NVIDIA ya ha llegado al techo de rendimiento de lo que es capaz de aportar la arquitectura Hopper, es por ello que realmente esta GPU es una NVIDIA Hopper H100 mejorada. Mejorada únicamente a nivel de memoria, claro.

Para crear inteligencia con aplicaciones de IA generativa y HPC, es necesario procesar grandes cantidades de datos a alta velocidad utilizando una memoria de GPU grande y rápida. Con NVIDIA H200, la plataforma de supercomputación de IA de extremo a extremo líder del sector acaba de volverse más rápida para resolver algunos de los retos más importantes del mundo

Información en torno a la NVIDIA Hopper H200

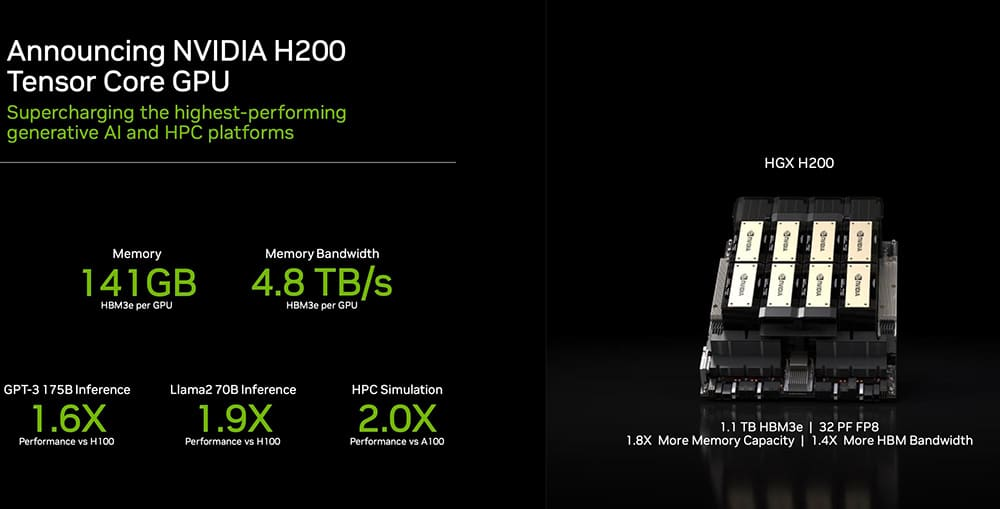

De esta forma, la NVIDIA H200 emplea el mismo chip gráfico con 16.896 CUDA Cores bajo un proceso de fabricación de 4 nm de TSMC. Este funciona exactamente a las mismas frecuencias que la H100. Esto implica alcanzar una velocidad de 1.850 MHz con un rendimiento FP32 de 67 FLOPs; FP16 de 1.979 FLOPs y 3.958 TOPs.

Las diferencias están a nivel de memoria. Mientras que la Hopper H100 usa hasta 80 GB de memoria HBM3 a 5,2 Gbps, la H200 alardea de ofrecer nada menos que hasta 141 GB a 6,5 Gbps. Esto implica pasar de un ancho de banda de 2.039 GB/s a nada menos que 4.800 GB/s. Esto permite llegar a ofrecer hasta un 90% de rendimiento extra en inferencia en el modelo de lenguaje LLaMA 2, y hasta un 60% en ChatGPT 3.

La introducción de H200 dará lugar a nuevos saltos de rendimiento, como la casi duplicación de la velocidad de inferencia en LLaMA 2, un LLM de 70.000 millones de parámetros, en comparación con H100. En futuras actualizaciones de software se esperan mejoras y liderazgo en rendimiento con H200.

Una futura NVIDIA Blackwell B100 será el doble de rápida que esta GPU

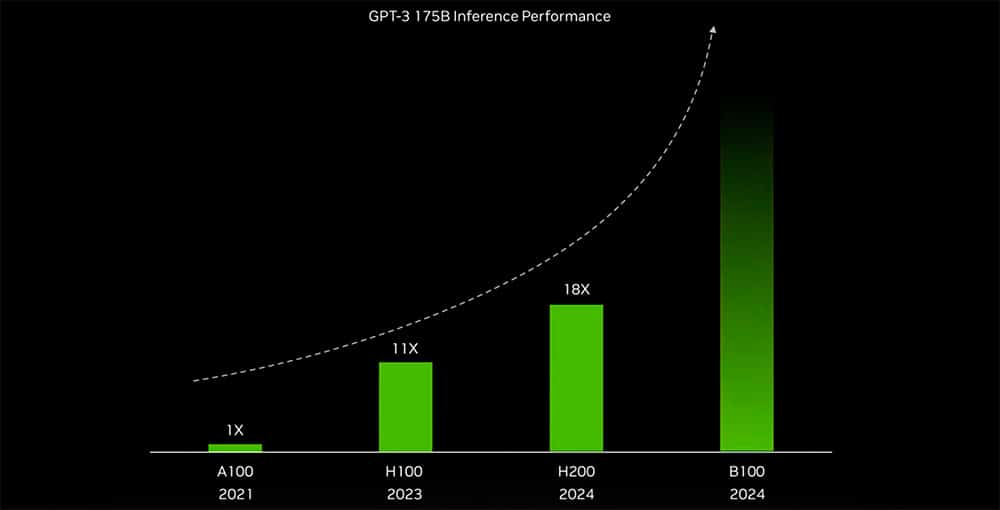

Adicionalmente, la compañía adelantó lo que podemos esperar de una NVIDIA B100 a nivel de rendimiento. Únicamente con ChatGPT 3, se espera multiplicar por dos el rendimiento de esta NVIDIA Hopper H200. Estamos ante una arquitectura que ha sido diseñada únicamente para acelerar la Inteligencia Artificial (IA). La nueva gallina de los huevos de oro tras la criptominería. No dieron más detalles, pero se espera que la NVIDIA B100 ofrezcan un mayor ancho de banda. Es decir, superar los actuales 4,8 TB/s de la NVIDIA H200.

Como no podía ser de otra forma, en lo que respecta a unas NVIDIA GeForce RTX 50, la compañía se mantuvo en silencio. Con unas GeForce RTX 40 SUPER para principios de 2024, aún queda bastante tiempo para que llegue un lanzamiento realmente relevante por parte de NVIDIA en este mercado.