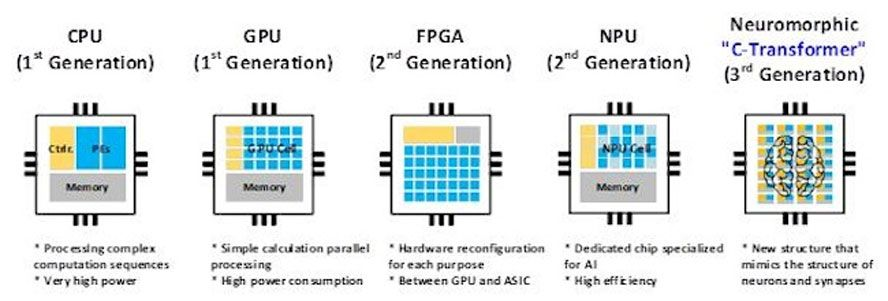

Un equipo de científicos del Instituto de Ciencia y Tecnología Avanzada de Corea (KAIST) presentó su chip de Inteligencia Artificial ‘Complementary-Transformer’ durante la reciente Conferencia Internacional de Circuitos de Estado Sólido de 2024 (ISSCC). Se afirma que el nuevo chip C-Transformer es el primer acelerador de IA de ultra bajo consumo capaz de procesar grandes modelos de lenguaje (LLM).

En un comunicado de prensa, los investigadores critican a Nvidia, afirmando que el C-Transformer consume 625 veces menos energía y es 41 veces más pequeño que la GPU A100 Tensor Core del equipo verde. También revela que los logros del chip fabricado por Samsung provienen en gran medida de la tecnología de computación neuromorfa refinada.

Aunque se nos dice que el chip C-Transformer de KAIST puede realizar las mismas tareas de procesamiento de LLM que una de las potentes GPU A100 de Nvidia, ninguno de los comunicados de prensa ni los materiales de la conferencia proporcionaron métricas de rendimiento comparativas directas. Esta es una estadística significativa, ausente de manera sospechosa, y los más cínicos probablemente supondrían que una comparación de rendimiento no favorece al C-Transformer.

La galería anterior muestra una ‘fotografía del chip’ y un resumen de las especificaciones del procesador. Puedes ver que el C-Transformer está fabricado actualmente con el proceso de 28 nm de Samsung y tiene un área de 20,25 mm2. Funciona a una frecuencia máxima de 200 MHz, consumiendo menos de 500 mW. En el mejor de los casos, puede lograr 3,41 TOPS. A simple vista, eso es 183 veces más lento que los 624 TOPS afirmados de la tarjeta Nvidia A100 PCIe (pero se afirma que el chip de KAIST consume 625 veces menos energía). Sin embargo, preferiríamos algún tipo de comparación de rendimiento con benchmark en lugar de mirar solo los TOPS afirmados de cada plataforma.

La arquitectura del chip C-Transformer es interesante de analizar y se caracteriza por tres bloques funcionales principales. Primero, hay un Núcleo Homogéneo DNN-Transformer / Spiking-transformer (HDSC) con una Unidad de Multiplicación-Acumulación Híbrida (HMAU) para procesar eficientemente la distribución de energía cambiante dinámicamente. En segundo lugar, tenemos una Unidad de Especulación de Salida de Pulsos (OSSU) para reducir la latencia y los cálculos del procesamiento de dominio de pulsos. En tercer lugar, los investigadores implementaron una Unidad de Generación de Pesos Implícitos (IWGU) con Compresión de Signos Extendida (ESC) para reducir el consumo de energía de Acceso a Memoria Externa (EMA).

Se explica que el chip C-Transformer no solo agrega algún procesamiento neuromorfo de adquisición para comprimir los grandes parámetros de LLM como su ‘salsa especial’. Anteriormente, la tecnología de computación neuromorfa no era lo suficientemente precisa para su uso con LLM, dice el comunicado de prensa de KAIST. Sin embargo, el equipo de investigación afirma que “logró mejorar la precisión de la tecnología para igualar la de las redes neuronales profundas (DNN)”.

Aunque existen incertidumbres sobre el rendimiento de este primer chip C-Transformer debido a la falta de comparaciones directas con aceleradores de IA estándar en la industria, es difícil refutar las afirmaciones de que será una opción atractiva para la computación móvil. También es alentador que los investigadores hayan llegado tan lejos con un chip de prueba de Samsung y extensas pruebas GPT-2.